В.Г. Мизяк, А.В. Шляева, М.А. Толстых

8

ние вычислений между процессами (для 40 из них) показано на рис. 3.

Видно, что для вычисления приземного анализа существенную роль

играет расположение наблюдений (процессы с 21 по 40 обрабатывают

широты Северного полушария, в котором находится больше призем-

ных наблюдений). На время вычисления анализа в свободной атмо-

сфере оказывает заметное влияние различная площадь широтных по-

лос в приполюсных и приэкваториальных областях. Было опробовано

распределение широтных полос между процессами, равномерное по

косинусу широты. Распределение вычислений показано на рис. 4. При

его использовании время счета сократилось на 20 %.

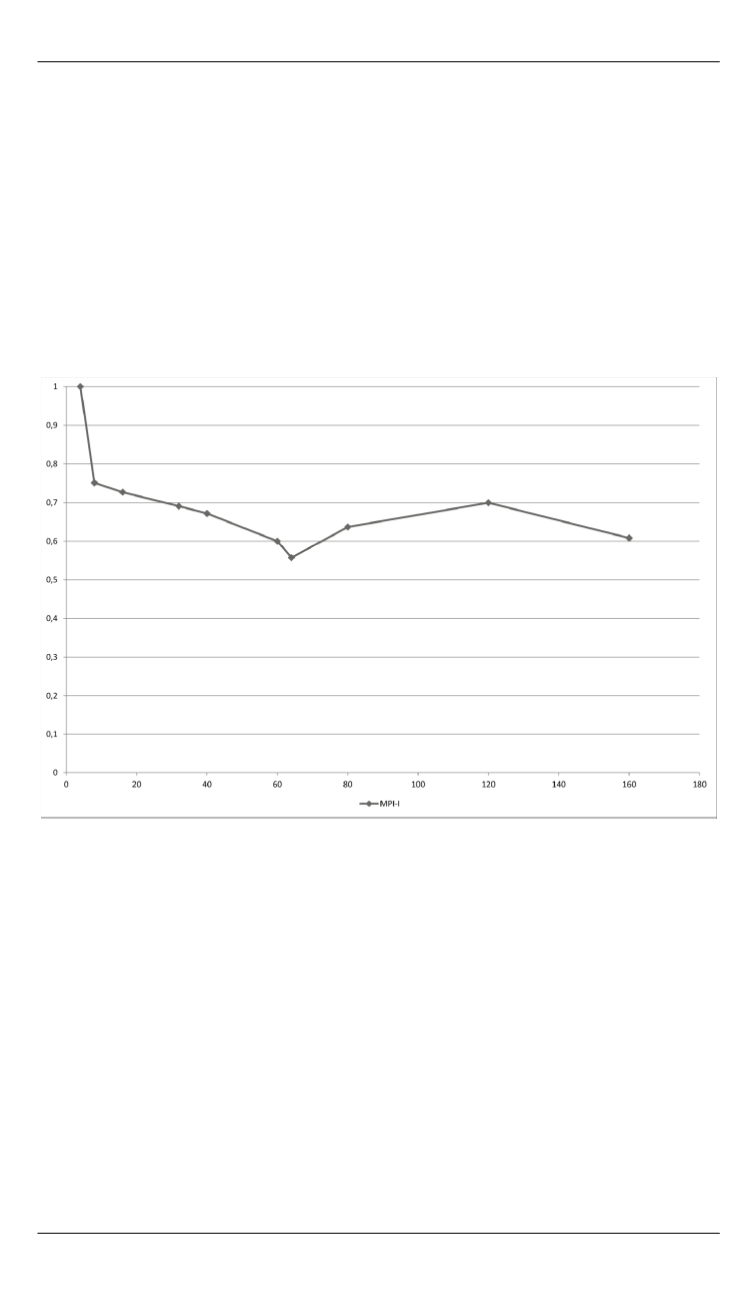

Рис. 2.

Эффективность при использовании 60 членов ансамбля

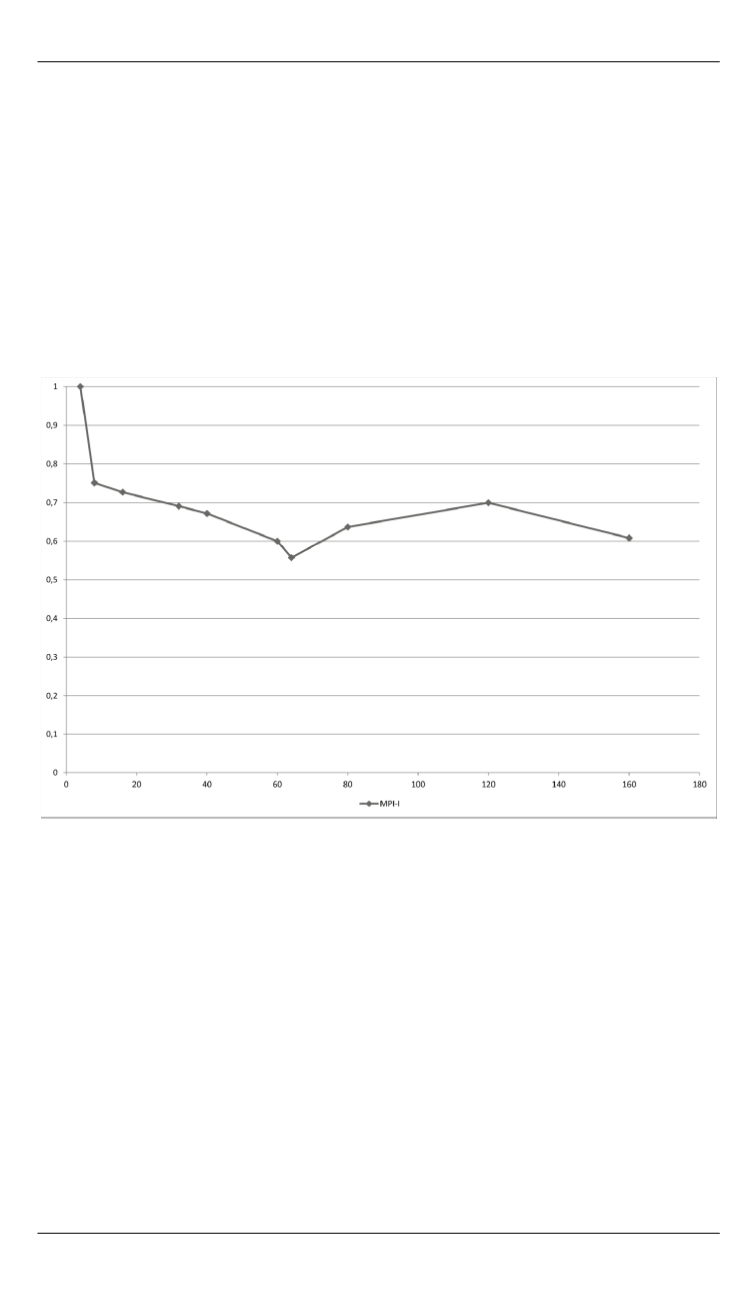

Известно, что использование односторонних коммуникаций,

например, из стандарта SHMEM, может ускорить работу параллель-

ной программы (например, [8]), поэтому в данной работе сравнивает-

ся также время работы программы при использовании двухсторонних

коммуникаций MPI-I и односторонних коммуникаций из стандарта

MPI-II (в двух вариантах — использование односторонней записи

(MPI_PUT) и одностороннего чтения (MPI_GET)). Вариант передачи

сообщений с помощью функционала библиотеки SHMEM признан

нами неперспективным в связи с ожидаемым переходом на другую

архитектуру. На рис. 5 приведены графики времени выполнения про-

граммы при использовании 40 членов ансамбля.